L'evento in pillole

L'evento si è svolto presso il Gran Visconti Palace a Milano con 44 partecipanti tra clienti e partner. I feedback sono stati molto positivi con un particolare interesse sui temi legati al mondo Cloud. La giornata ha visto coinvolti vari speaker dal responsabile della divisione DPS in Italia a vari esperti sui temi della Data Protection.

La Vision

L'apertura dell'evento ha visto protagonista Francesco Isabelli responsabile commerciale della divisione DPS in Italia che ha presentato la vision di EMC ben riassunta nella whiteboard riportata di seguito:

La whiteboard mette in evidenza alcune informazioni raccolte attraverso una ricerca di mercato:

- il 71% dei clienti intervistati non è confidente nella sua strategia di Data Protection

- il 64% dei clienti continua ad oggi ad avere problematiche di data loss

- il 76% dei clienti non ha una strategia di data protection per le applicazioni Cloud

Ripercorrendo le informazioni statistiche di quest'analisi è possibile vedere come la vision di EMC permette di rispondere in modo efficace a tutte queste situazioni:

- le soluzioni di Data Protection di EMC sono leader di mercato e permettono di definire una strategia precisa e sicura per il cliente

- la garanzia sulla protezione del dato attraverso l'utilizzo di EMC Data Domain unico a garantire la restorabilità del dato grazie alla Data Invulnerability Architecture

- l'apertura delle soluzioni al Cloud attraverso Spanning, Mozy e Cloud Boost

L'apertura al mondo Cloud è stato il tema di maggior interesse per i partecipanti che hanno riportato commenti molto positivi sulla strategia EMC.

Data Protection Search e DPA

Tra le novità di EMC world 2015 è stata annunciata la prima release della funzionalità di Data Protection Search basata su elastich search che permette di gestire delle ricerche all'interno dei backup con un interfaccia Google Like.

Durante l'evento è stata visualizzato un video che spiega l'architettura e fa una demo della soluzione

Sono state illustrate le nuove funzionalità di DPA ed in particolare la root cause analisi che fa un analisi di tutti gli eventi tracciati dal sistema per determinare la possibile causa del fallimento di un backup. Questa nuova funzionalità è veramente unica ed è un esempio reale di applicazione dei big data all'interno del mondo dei backup.

Annunci EMC Data Domain

L'evoluzione in ambito EMC Data Domain è stata annunciata durante EMC World 2015 con i nuovi gioielli di famiglia il modello di punta DD9500 e l'entry level DD2200 con 4TB.

Le altre novità molto interessanti sono il progetto Falcon che prevede l'introduzione sul mercato di un EMC Data Domain virtuale software only

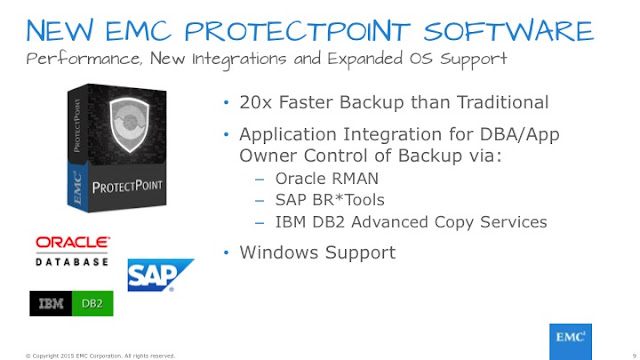

E l'introduzione in ambito protect point del supporto per Oracle RMAN, SAP BR*Tools e DB2:

Spanning, Cloud Boost, Mozy & Recover Point for Virtual machines

Hanno destato molto interesse nella platea le novità relative al Cloud:

- Spanning backup Cloud to Cloud di Office 365, Google Apps e Salesforce

- Cloud Boost che abilita la scrittura in Cloud dei dati di Networker e Avamar

- Un update sulle funzionalità di Mozy

Spanning

Spanning da la possibilità di gestire la protezione delle applicazioni SaaS. In generale le applicazioni SaaS offrono la garanzia della disponibilità dei dati ma non il ripristino di elementi modificati o cancellati erroneamente o in modo fraudolento. Ed è qui che Spanning si inserisce come elemento di garanzia dell'integrità dei dati SaaS.Cloud Boost

La nuova funzionalità di Cloud Boost aggiunge alla famiglia di soluzioni Data Protection Suite l'opzione di poter scrivere in Cloud i dati di backup. Questo permette di poter valutare uno spazio Cloud a basso costo per la scrittura dei backup long term. Tale opzione permette di gestire in modo più semplice un architettura Tapeless che combina EMC Data Domain per i dati daily e con retention basse e il Cloud per i dati a lunga ritenzione.Mozy Update

Nello scenario dei BaaS Mozy è un attore rilevante sul mercato e la sua crescita è dovuta alla costante innovazione del prodotto e all'ampiamento degli uses case a cui si applica. Ad oggi la soluzione permette di gestire il backup in Cloud sia delle postazioni di lavoro che di ROBO attraverso le nuove funzionalità di gestione dei backup di macchine Linux, integrazione con VmWare e Hyper-v.

Recover Point for Virtual Machine

Recover Point for Virtual Machine è una soluzione completamente software per la gestione del Disaster Recovery degli ambienti virtuali. Si integra con vCenter e permette di gestire una protezione sia locale che remota delle macchine virtuali indipendente dallo storage e/o protocolli utilizzati nell'infrastruttura.

La soluzione permette di gestire anche un piano di DR con la creazione di workflows di ripartenza delle VM personalizzati.

La soluzione permette di gestire anche un piano di DR con la creazione di workflows di ripartenza delle VM personalizzati.

At the end...

At the end...