Lo scenario delle minacce che ci troviamo a fronteggiare oggi non è cambiato (in meglio) nel corso degli ultimi mesi, anzi tutti i fenomeni più rilevanti e pericolosi si sono evoluti e inaspriti sia in termini qualitativi che quantitativi. Le statistiche ad esempio ci dicono che gli attacchi mirati sono in continua crescita:

- La distribuzione degli stessi che tiene sempre meno conto della dimensione dell’organizzazione

- Il rischio di essere sotto attacco sia di per sé molto alto come valore assoluto

- Le campagne di attacco sono sempre più precise e durature

- La componente accidentale (ossia dovuta alla dis-educazione dell’utente) predominante nel passato, è ora superata da tutte quelle forme che coinvolgono un intervento esterno (hacker, hacktivism, cyber-crime, ecc).

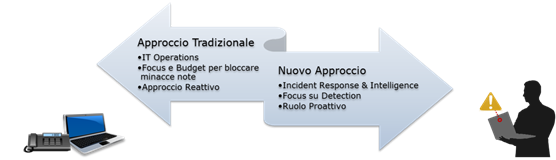

- Lavorare con lo stesso approccio che si utilizza per difendersi dalle minacce tradizionali (queli erano virus, spam, ecc) in cui la sicurezza assume un ruolo per lo più di IT Operations (ossia gestire le credenziali, imporre i cambi password, monitorare i dispositivi, ecc.), con attenzione (e budget) rivolti per lo più a tecnologie preventive con un attitudine reattiva alle minacce a cui si è soggetti

- Oppure, data la natura sostanzialmente differente delle minacce attuali e il forte impatto negativo sul business che esse possono avere, adottare un approccio differente, in cui la sicurezza ha un ruolo proattivo, le competenze e gli strumenti per rispondere agli incidenti informatici, con attenzione rivolta all’analisi, all’investigazione, alla detection e con capacità di generare e far leva su dati di intelligence a beneficio dell’intera organizzazione. Un vero e proprio strumento a supporto del business aziendale.

Per fare tale passo, che necessariamente rappresenta un salto di qualità e maturità per molte organizzazioni, ogni singola persona, le tecnologie che esse utilizzano e il modo stesso di lavorare deve adattarsi al dinamico e sempre più complesso panorama delle minacce che ci si trova a fronteggiare. Alcune organizzazioni hanno quindi già avuto modo di instituire, come naturale evoluzione, una sorta di «centro di controllo» specializzato ad individuare, investigare e rimediare incidenti di cyber-security a cui si fa riferimento a seconda dei casi come SOC o CIRC. Tuttavia è sempre importante ricordare che il SOC non si traduce necessariamente nell’immagine che abbiamo in testa di una stanza piena di videowall (e persone).

Anche un singolo individuo che lavora diversamente e che persegue questo nuovo approccio di cui abbiamo parlato può di per sé aiutare a fronteggiare il preoccupante scenario delle minacce descritto in precedenza.

Nell’articolo successivo, analizzeremo l’importanza di coordinare all’unisono Persone, Processi e Tecnologie al fine di rispondere agli Incidenti di Sicurezza in modo veloce, efficace e coerente.

Davide Veneziano – RSA Security Analytics Pre Sales Consultant

Francesco Gelo – RSA Pre Sales Consultant

https://blogs.rsa.com/category/advanced-security/