Buona parte del mio lavoro di System Engineer si svolge

dai clienti. Negli ultimi anni, ho lavorato con realtà aziendali che

conoscevano poco EMC, ed è stato molto interessante per me capire le loro

percezioni sulla strategia e la visione di EMC. Nelle discussioni avute, un

tema frequente riguardava l'estrema varietà del nostro offering: EMC appariva loro come un'azienda leader di settore ma con

un’offerta troppo estesa in termini di:

1) Portafoglio prodotti.

2) Funzionalità e gestione dei prodotti stessi.

Mi veniva sovente fatto notare come sul mercato esistano

delle soluzioni semplici che fanno TUTTO mediamente bene e che lo fanno in modo

apparentemente semplice; EMC invece, ha tante soluzioni diverse che spesso

presentano delle aree di overlap in termini di funzionalità e posizionamento.

Effettivamente, se osserviamo quali e quante famiglie di

prodotti EMC possiede nella categoria dei Block e File Storage (ciascuna poi da

declinare in diverse configurazioni distinte)..

….possiamo contarne ben 7 includendo anche ATMOS che,

sebbene nella sua accezione prediletta vada definito Object Storage, può

eventualmente erogare anche servizi CIFS/NFS e quindi essere classificato come

File Storage.

Se consideriamo inoltre la pletora infinita di

funzionalità che ciascun prodotto si porta dietro, e che un cliente potrebbe

percepire come un aggravio di conoscenza da acquisire, è facile capire perché

tanto spesso mi siano state chieste delucidazioni sui razionali di questa

strategia:

E' davvero la strategia vincente? E' davvero ancora

necessaria la diversificazione di prodotto nel mondo dell'IT

quando ci sono vendor che, apparentemente, con un singolo prodotto coprono a

360 gradi tutte le necessità? E' ancora necessaria la diversità quando la

virtualizzazione ha uniformato e standardizzato il mondo IT? A chi dare fiducia

quando le strategie (anche se forse sarebbe meglio chiamarle filosofie) che

guidano le aziende sono diametralmente opposte?

Per rispondere a queste domande vorrei ricorrere ad una

analogia con l'ecosistema naturale all'interno del quale l'essere umano si è

evoluto. Se osserviamo l'evoluzione dell'ecosistema terrestre ci accorgiamo

come la biodiversità non si sia rivelata soltanto la migliore strategia per

garantire la sopravvivenza delle singole specie ma anche la migliore per

salvaguardare l'intero ecosistema.

In altre parole, vegetali e animali si sono adattati in

modo estremamente variegato per rispondere alle diverse condizioni ambientali,

acquisendo caratteristiche peculiari più adatte per resistere agli

"stress" ambientali. E così il "pino silvestre" si è

adattato con le foglie ad ago alle temperature rigide, mentre il "ficus

elastica" si è adattato con larghe foglie ovali ai climi tropicali.

In altre parole, il modello "One-Fits-All" in

natura non ha funzionato perché i compromessi necessari per creare un'unica

specie che potesse vivere dai -70 gradi del polo sud ai +50 gradi del deserto

del sahara l'avrebbero resa completamente inadatta alla vita.

Uscendo dall'analogia naturale, io credo che anche

all'interno dell'ECOSISTEMA CLIENTE i needs tecnologici e di business cambiano

in modo estremo. Per sopravvivere nell'ecosistema di un cliente, la strategia

migliore per un'azienda come EMC è quella di creare le migliori soluzioni

specializzate, facendo poi in modo che possano cooperare l’una con l’altra

nella realizzazione di un’unica architettura.

Allo stesso tempo, anche per il cliente conviene

scegliere la migliore tecnologia per soddisfare i propri bisogni ed essere

vincente sul mercato. La ragione per cui, all'interno di EMC, la prevendita

ricopre un ruolo chiave è proprio perché sa capire i clienti e aiutarli a

scegliere lo strumento giusto per soddisfare i diversi bisogni.

Assodato quindi che una strategia di prodotto

diversificata sia assolutamente necessaria sia per un vendor che per un cliente

finale, resta da capire se e come sia possibile ridurre invece il tema della

complessità operativa che la diversificazione comporta. Se ci pensiamo bene, il

"come" è noto ormai dagli albori dell'informatica ed è

indirizzato attraverso il concetto di astrazione. Spesso l'astrazione

viene associata al concetto virtualizzazione ma in realtà quest'ultima non è

che una conseguenza della prima.

Un metodo abbastanza comune di astrazione nel mondo

informatico è la creazione di interfacce per esportare funzioni di alto livello

di un sistema complesso.

Il potere delle interfacce

Il grande potere delle interfacce è che, la conoscenza

delle stesse, permette di interagire con un sistema esterno all'utilizzatore

pur non conoscendone i dettagli di funzionamento. Esempi tipici di interfaccia

nel mondo informatico sono le API (Application Programming Interface) ma le

interfacce sono attorno a noi anche nel mondo reale: il volante e i pedali

permettono di interagire con un'auto indipendentemente dal fatto che il

guidatore sappia come funzioni il motore e il sistema di trasmissione. In

questo senso, il volante e i pedali sono le interfacce che ci permettono di

governare il sistema complesso "automobile".

Un set di interfacce standardizzato diventa un protocollo

di comunicazione. Nel mondo ideale, i protocolli dovrebbero essere definiti in

modo indipendente dall'implementazione: in altre parole, bisognerebbe prima

pensare alle interfacce e poi all'implementazione delle stesse. Nel mondo

dell'informatica questo è avvenuto raramente: ciascun vendor ha realizzato implementazioni di funzionalità senza pensare

al modo di interfacciarsi verso il mondo esterno in modo interoperabile e

questo ha causato un proliferare di soluzioni incompatibili e con sistemi di

controllo diversificati.

Nel mondo del computing, tuttavia, la virtualizzazione

delle Hypervisor, introducendo un altro livello di astrazione, è riuscita a

semplificare l'interoperabilità di soluzioni hardware differenti tra di loro e

risposto affermativamente alla domanda "E' possibile ridurre il tema della

complessità operativa in un mondo di soluzioni Hardware diversificato?".

Se si è riusciti nel mondo del computing, non si può

pensare replicare quanto già fatto anche per il mondo dello Storage?

EMC ViPR (pronunciato VIPER)

ViPR è la risposta di EMC. ViPR è una soluzione software

che astrae le risorse storage disponibili disaccoppiando il control plane (la

logica di controllo di un sistema storage) e il data plane (il percorso che i

dati fanno da e verso i sistemi storage).

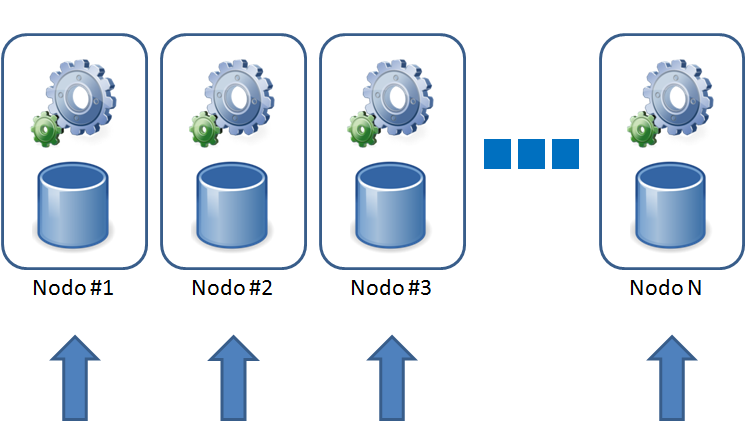

Le risorse storage vengono aggregate in pool e presentate

in modo trasparente agli storage-consumer/administrators attraverso un catalogo

self-service.

ViPR astrae la complessità del processo di provisioning

di un sistema storage attraverso una interfaccia semplificata e si occupa della

gestione di tutto il processo che va dall'allocazione dello spazio alla sua

presentazione all'end-user finale. Allo stesso tempo, non interponendosi come

strato di virtualizzazione per il data plane, fa si che le applicazioni possano

sfruttare tutte le caratteristiche dei sistemi storage sottostanti incluso il

virtual provisioning, la deduplica, la compressione e le funzionalità avanzate

di replica locale e remota.

In questo modo, anche in un ECOSISTEMA CLIENTE variegato,

dove le tecnologie storage sono diverse per matchare i needs del cliente, è

possibile interagire con esse in un modo più semplice non dovendo

necessariamente conoscere, ad esempio, i dettagli di funzionamento del

provisioning di un sistema VMAX, VNX, XtremIO e/o Terze Parti.

ViPR, inoltre, espone API per essere integrato in

meccanismi di automazione più vasti con l'obiettivo di realizzare un Software

Defined Data Center (SDDC) dove ogni elemento dell'infrastruttura può essere

controllato in modo intelligente per adattarsi in modo trasparente ai bisogni

del business. L'immagine sottostante illustra come uno stack applicativo basato

su VMWARE ed una infrastruttura storage disaccoppiata da ViPR, si interconnetta

e comunichi la disponibilità di servizi di alto livello agli strati di

orchestrazione evoluti (vCloud Automation Center e vCenter Ops Manager)

attraverso il control plane.

In conclusione, il commitment tecnologico di EMC su

piattaforme storage diversificate è e resterà elevatissimo per fornire sempre

la migliore soluzione ai nostri clienti ma, allo stesso tempo, la nuova

esigenza di semplificazione per la realizzazione Software Defined DataCenter

sta spingendo EMC a realizzare una visione nuova in cui l'automazione, la

semplificazione e l'interoperabilità diventano la chiave di volta per aiutare i

suoi clienti a vincere sul mercato.

AP